Física de Sistemas Complejos aplicada a la estimación de Peligro Sísmico

La litósfera es la capa más superficial de la tierra, la cual está formada por bloques constitutivos que a grosso modo podemos clasificar con la secuencia: rocas, conglomerados, formaciones, yacimientos, cordilleras, placas tectónicas. Entre estos bloques existen bordes que los limitan, también llamados fallas. En las fallas, los bloques se desplazan con movimiento relativo entre sí. A veces lo hacen de forma abrupta, pudiéndose percibir y localizar eventos sísmicos.

Aunque sabemos que los terremotos corresponden a liberación de energía elástica, debido a que la totalidad del proceso dinámico en la litósfera es aún inaccesible para los métodos modernos, no los podemos pronosticar con certeza absoluta ni atribuirles una causa específica. Sin embargo, podemos entender cada evento sísmico como una “marca” de la dinámica del sistema, es decir, un producto de las interacciones que se producen entre sus bloques constituyentes.

Esta es la visión de la litósfera como un sistema complejo, es decir, un sistema constituido por muchas partes que interactúan entre sí. Las interacciones dan lugar a un proceso planetario de liberación de energía sísmica que abarca múltiples escalas, con terremotos de variadas magnitudes y distintas ventanas temporales.

Los terremotos son un fenómeno físico ampliamente extendido en el territorio chileno, dado el contexto tectónico de subducción en el cual está inserto su geografía. Se puede considerar que son la mayor amenaza natural para el país, ya que las estadísticas de las principales catástrofes ocurridas desde el año 1906 muestran que el 99 % de las pérdidas humanas y materiales fueron generadas por este tipo de eventos.

El asesoramiento en riesgo de desastres ocasionados por eventos sísmicos requiere una adecuada comprensión de cómo funciona el sistema y del proceso de generación de sismicidad. Uno de los mayores desafíos es estimar el comportamiento de una zona sismogénica en base a la estadística de una región mayor, lo cual equivale a comprender cómo actúa el fenómeno en las escalas de interés. Los catálogos sísmicos son nuestra principal fuente de información. Su estudio estadístico y modelación física permite desarrollar herramientas para cuantificar el peligro sísmico en la geografía del país.

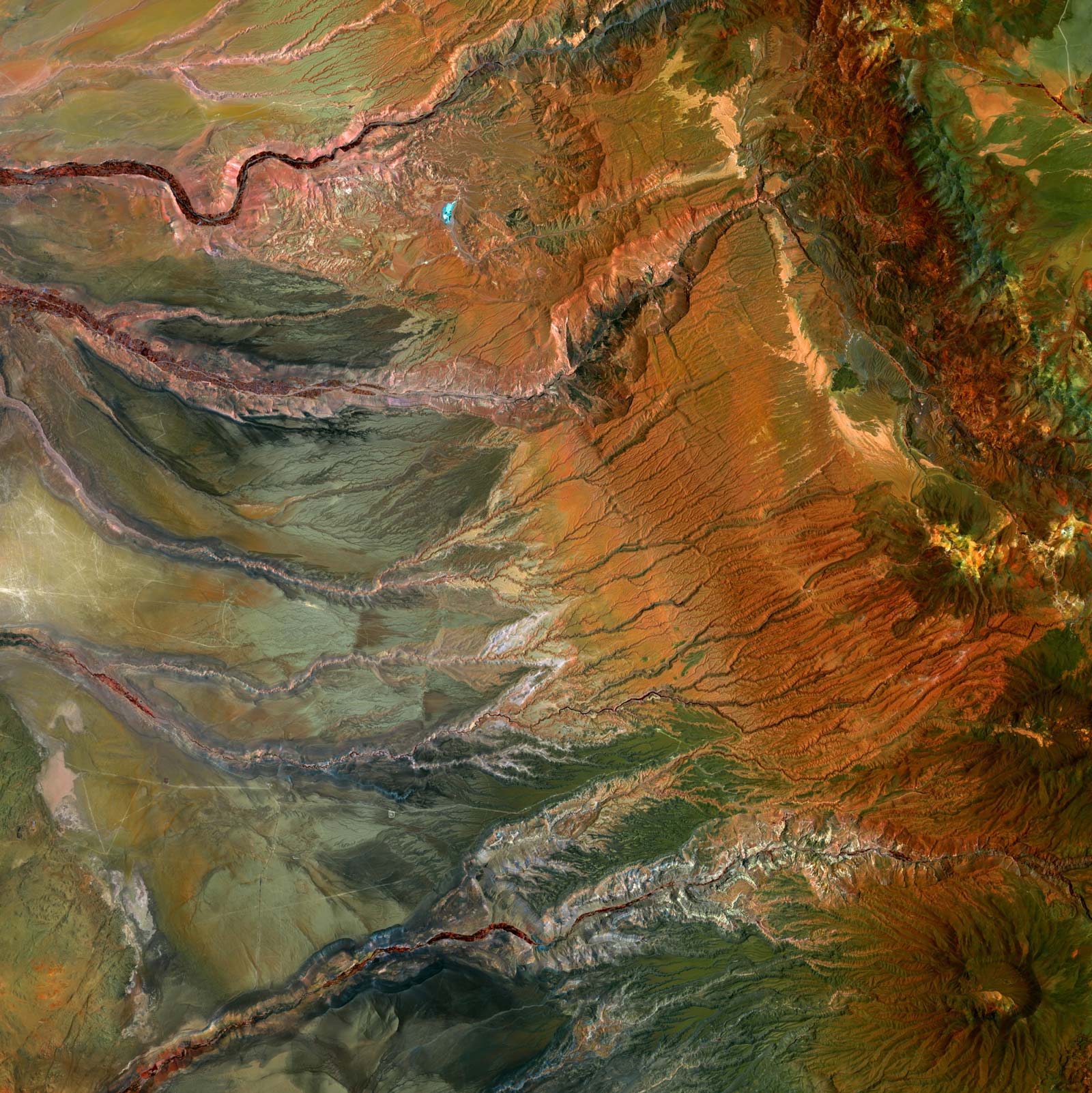

Figura 1. Dimensión fractal: Un adecuado asesoramiento de peligro sísmico requiere entender cómo se organiza la sismicidad en las distintas escalas de interés. Los epicentros de los terremotos ocurren en patrones complejos que pueden ser caracterizados mediante el cálculo de su dimensión fractal. Esta cantidad refleja como los puntos ocupan el espacio, así como los cristales de agua se extienden en un cono de nieve. El cálculo de la distribución fractal permite entender cómo cambia el peligro sísmico al considerar objetos expuestos de distinto tamaño, como lo pueden ser comunas, provincias o regiones.

Figura 1. Dimensión fractal: Un adecuado asesoramiento de peligro sísmico requiere entender cómo se organiza la sismicidad en las distintas escalas de interés. Los epicentros de los terremotos ocurren en patrones complejos que pueden ser caracterizados mediante el cálculo de su dimensión fractal. Esta cantidad refleja como los puntos ocupan el espacio, así como los cristales de agua se extienden en un cono de nieve. El cálculo de la distribución fractal permite entender cómo cambia el peligro sísmico al considerar objetos expuestos de distinto tamaño, como lo pueden ser comunas, provincias o regiones.

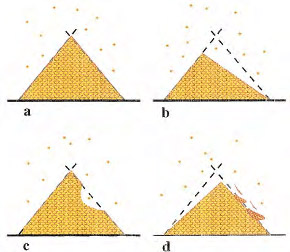

Video: En el grupo de sistemas complejos del PRS se han estudiado e implementado modelos computacionales, en la línea de los autómatas celulares. Estos corresponden a simulaciones en grillas finitas de las interacciones que presenta un sistema, a partir de la relación de un elemento con sus vecinos más cercanos. Se han utilizado en prácticamente todas las ramas de las ciencias, tanto naturales como sociales, para explicar la emergencia de propiedades como propagación de enfermedades infecciosas, el vuelo colectivo de bandadas de aves, los patrones que forman las plantas, incendios forestales, pilas de arena, entre otros. Esta simulación corresponde a un modelo de clusterización para la representación de la generación de terremotos en la litósfera terrestre. Un sistema acoplado tiende a su punto crítico donde sufre avalanchas en formas de eventos sísmicos que abarcan todas las longitudes del sistema.

Figura 3

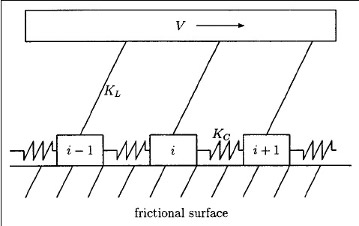

Figura 3 Figura 4. Bloques y resortes: el modelo de Burridge-Knopoff

Figura 4. Bloques y resortes: el modelo de Burridge-Knopoff